Sobre el «Chatbot»…

The New York Times(C.Metz/S.Lohr)Microsoft lanzó una versión nueva de su motor de búsqueda Bing que, a diferencia de los buscadores actuales, incluye un chatbot que puede responder a preguntas en una prosa clara y concisa.

Desde entonces, las personas han notado que parte de lo que el chatbot de Bing genera es impreciso, engañoso y francamente raro, lo que genera temores de que sea consciente o que pueda experimentar el mundo que le rodea.

Pero eso no es así. Y, para entender por qué, es importante saber cómo funcionan los chatbots.

– ¿El chatbot está vivo?

No. Que quede claro: ¡no!

En junio, un ingeniero de Google, Blake Lemoine, afirmó que una tecnología de chatbots similar que es evaluada dentro de Google tenía conciencia. Eso es falso. Los chatbots no están conscientes y no son inteligentes… al menos no de la manera en que los humanos son inteligentes.

– Entonces, ¿por qué parece vivo?

Retrocedamos un poco. El chatbot de Bing es operado por un tipo de inteligencia artificial llamada red neuronal. Eso podría sonar como un cerebro computarizado, pero el término es engañoso.

Una red neuronal es tan solo un sistema matemático que aprende habilidades al analizar cantidades vastas de datos digitales. A medida que una red neuronal examina, por ejemplo, miles de fotografías de gatos, puede aprender a reconocer a un gato.

La mayoría de las personas usan redes neuronales todos los días. Es la tecnología que identifica a personas, animales de compañía y otros objetos en imágenes publicadas en servicios de internet como Google Fotos. Les permite a Siri y Alexa, los asistentes de voz parlanchines de Apple y Amazon, reconocer las palabras que dices. Además, es lo que traduce entre inglés y español en servicios como Traductor de Google.

Las redes neuronales son muy buenas para imitar el modo en que los humanos usan el lenguaje y eso puede confundirnos hasta pensar que la tecnología es más poderosa de lo que en realidad es.

– ¿Cómo imitan al lenguaje humano las redes neuronales, exactamente?

Hace alrededor de cinco años, investigadores en compañías como Google y OpenAI, una empresa emergente con sede en San Francisco que hace poco lanzó el popular chatbot ChatGPT, comenzaron a crear redes neuronales que aprendían de cantidades enormes de texto digital, incluyendo libros, artículos de Wikipedia, registros de chats y todo tipo de otras cosas publicadas en internet.

Estas redes neuronales son conocidas como grandes modelos de lenguaje. Son capaces de usar esos montones de datos para armar lo que podrías llamar un mapa matemático de lenguaje humano. Al emplear este mapa, las redes neuronales pueden realizar muchas labores, como escribir sus propios tuits, redactar discursos, generar programas informáticos y, sí, sostener una conversación.

Estos grandes modelos de lenguaje han probado ser útiles. Microsoft ofrece una herramienta, Copilot, que se construyó con un gran modelo de lenguaje y puede sugerir la siguiente línea de código conforme los programadores de computadoras crean aplicaciones de software, en una manera muy parecida a como las herramientas de autocompletado sugieren la siguiente palabra cuando escribes mensajes de texto o correos electrónicos.

Otras compañías ofrecen tecnología similar que puede generar materiales de mercadotecnia, correos electrónicos y otros textos. Este tipo de tecnología también es conocida como inteligencia artificial generativa.

– ¿Ahora las compañías están lanzando versiones de esto con las que puedes chatear?

Exacto. En noviembre, OpenAI lanzó ChatGPT, la primera vez que el público en general pudo probar esto. La gente se maravilló… y con justa razón.

Estos chatbots no chatean exactamente como un humano, pero a menudo parecen hacerlo. También pueden escribir trabajos finales, poesía y conversar sobre casi cualquier tema que se les presente.

– ¿Por qué se equivocan?

Porque aprenden de internet. Piensa sobre cuánta información errónea y otra basura hay en la web.

Estos sistemas tampoco repiten lo que está en internet palabra por palabra. Con base en lo que han aprendido, producen texto nuevo por su cuenta, algo que los investigadores de inteligencia artificial llaman una “alucinación”.

Es por esto que los chatbots pueden darte respuestas diferentes si haces la misma pregunta dos veces. Responden cualquier cosa, ya sea que esté basada en la realidad o no.

– Si los chatbots ‘alucinan’, ¿eso no significa que tienen conciencia?

A los investigadores de inteligencia artificial les encanta usar términos que hacen parecer humanos a estos sistemas. Sin embargo, alucinar solo es un término pegajoso para “inventan cosas”.

Eso suena espeluznante y peligroso, pero no significa que la tecnología esté viva o consciente de sus alrededores de ninguna forma. Solo está generando texto utilizando patrones que encontró en internet. En muchos casos, mezcla y combina patrones ce maneras sorprendentes y perturbadoras. No obstante, no está consciente de lo que está haciendo. No es capaz de razonar como lo hacen los humanos.

– ¿Las compañías no pueden evitar que los chatbots actúen de modo extraño?

Lo están intentando.

Con ChatGPT, la empresa OpenAI intentó controlar el comportamiento de la tecnología. Cuando un grupo pequeño de personas probó en privado el sistema, OpenAI les pidió que calificaran sus respuestas. ¿Fueron útiles? ¿Fueron veraces? Luego, OpenAI empleó estas calificaciones para perfeccionar el sistema y definir con mayor cuidado lo que la tecnología haría y lo que no haría.

No obstante, tales técnicas no son perfectas. Los científicos en la actualidad no saben cómo construir sistemas que sean completamente veraces. Pueden limitar las imprecisiones y las respuestas raras, pero no pueden detenerlas. Una de las formas de frenar los comportamientos extraños es mantener los chats breves.

No obstante, los chatbots seguirán diciendo cosas que no son ciertas. Además, mientras otras compañías comienzan a desplegar estos tipos de bots, no todas serán buenas para controlar lo que estos pueden y no pueden hacer.

La conclusión: no creas todo lo que te diga un chatbot.

– ¿Por qué son mentirosos y errantes los chatbots? Mírate al espejo

Cuando Microsoft agregó un chatbot a Bing, su motor de búsqueda, la gente se dio cuenta de que ofrecía todo tipo de información falsa sobre Gap, la vida nocturna mexicana y la cantante Billie Eilish.

Luego, cuando periodistas y otros de los primeros usuarios de prueba entablaron largas conversaciones con el bot de inteligencia artificial (IA) de Microsoft, este comenzó a mostrar un comportamiento grosero y perturbador.

En los días transcurridos desde que la conducta del bot de Bing se convirtió en una sensación mundial, a la gente le ha costado comprender la rareza de esta nueva creación. La mayoría de las veces, los científicos han afirmado que buena parte de la culpa recae en los humanos.

Sin embargo, sigue habiendo cierto misterio en torno a lo que es capaz de hacer el nuevo chatbot y su motivación para hacerlo. Su complejidad lo vuelve difícil de analizar y todavía más difícil de predecir, además de que los investigadores lo están estudiando a través de una lente filosófica y también conforme al código duro de las ciencias de la computación.

Como cualquier otro estudiante, un sistema de inteligencia artificial puede aprender mala información de malas fuentes. ¿Y a qué se debe ese extraño comportamiento? Puede ser el reflejo distorsionado que hace un chatbot de las palabras e intenciones de las personas que lo utilizan, comentó Terry Sejnowski, neurocientífico, psicólogo y especialista en computación que ayudó a sentar las bases intelectuales y técnicas de la inteligencia artificial moderna.

“Esto ocurre cuando profundizas cada vez más en estos sistemas”, explicó Sejnowski, profesor del Instituto Salk de Estudios Biológicos y la Universidad de California, campus San Diego, quien el mes pasado publicó un trabajo de investigación sobre este fenómeno en la revista científica Neural Computation. “Busques lo que busques, —desees lo que desees—, te lo van a dar”.

Terry Sejnowski, profesor de la Universidad de California en San Diego, cree que los comportamientos extraños de los chatbots pueden ser un reflejo de las personas que los utilizan.

Google también presumió un nuevo chatbot, Bard, pero los científicos y periodistas se dieron cuenta de inmediato de que escribía disparates sobre el Telescopio Espacial James Webb. OpenAI, una empresa emergente de San Francisco, inició el auge de los chatbots en noviembre cuando presentó ChatGPT, un bot que tampoco dice siempre la verdad.

Los nuevos chatbots tienen como base una tecnología que los científicos llaman modelos lingüísticos de gran tamaño (LLM, por su sigla en inglés). Estos sistemas aprenden analizando enormes cantidades de texto digital extraído del internet, que incluye volúmenes de material falso, tendencioso y, por lo demás, tóxico. El texto del que aprenden los chatbots también está un poco pasado de moda, porque deben analizarlo durante meses antes de que el público pueda usarlos.

Mientras analiza ese mar de información buena y mala de todo el internet, un LLM aprende a hacer una cosa en particular: adivinar la siguiente palabra de una secuencia de palabras.

Funciona como una versión gigante de la tecnología de autocompletar que te sugiere la siguiente palabra cuando escribes un correo electrónico o un mensaje instantáneo en tu teléfono inteligente. En la secuencia “Tom Cruise es un ____”, el LLM podría adivinar “actor”.

Cuando conversas con un chatbot, este no solo recurre a todo lo que ha aprendido de internet. Utiliza todo lo que tú le has dicho y todo lo que te ha respondido. No solo adivina la siguiente palabra de su frase. Está adivinando la siguiente palabra del largo bloque de texto que incluye tanto tus palabras como las suyas.

Mientras más larga se vuelve la conversación, mayor la influencia que tiene el usuario sobre lo que dice el chatbot sin saberlo. Si quieres que se enoje, se enoja, comentó Sejnowski. Si lo alientas para que se ponga raro, se pone raro.

Las reacciones de alarma ante el extraño comportamiento del chatbot de Microsoft eclipsaron un punto importante: el chatbot no tiene personalidad. Ofrece resultados instantáneos que escupe un algoritmo informático increíblemente complejo.

Microsoft pareció frenar el comportamiento más extraño cuando puso un límite a la duración de las conversaciones con el chatbot de Bing. Fue como enterarse gracias al piloto de pruebas de un auto que ir demasiado rápido durante demasiado tiempo quema su motor. OpenAI, socio de Microsoft, y Google también están explorando formas de controlar el comportamiento de sus bots.

Pero esta tranquilidad tiene una salvedad: como los chatbots aprenden de tanto material y lo combinan de forma tan compleja, los investigadores no tienen del todo claro cómo producen sus resultados finales. Los investigadores observan lo que hacen los robots y aprenden a poner límites a ese comportamiento, a menudo después de que se produce.

Sam Altman dirige OpenAI, un estrecho colaborador de Microsoft en el desarrollo de inteligencia artificial.

Microsoft y OpenAI han decidido que la única manera de averiguar qué harán los chatbots en el mundo real es darles rienda suelta… y contenerlos cuando se salgan del camino. Ambas compañías creen que su gran experimento público vale la pena el riesgo.

Sejnowski comparó el comportamiento del chatbot de Microsoft con el Espejo de Oesed, un artefacto místico de las novelas de Harry Potter de J. K. Rowling y muchas de las películas basadas en su mundo ingenioso de jóvenes magos.

“Oesed” es “deseo” al revés. Cuando la gente descubre el espejo, este parece brindarles verdad y comprensión. Sin embargo, no es así: muestra los deseos más profundos de cualquiera que vea su reflejo en él. Y algunas personas se vuelven locas si lo miran demasiado tiempo.

“Debido a que los humanos y los LLM se reflejan entre sí, con el tiempo tenderán hacia un estado conceptual común”, explicó Sejnowski.

Según Sejnowski, no debería sorprendernos que los periodistas hubieran empezado a ver un comportamiento extraño en el chatbot de Bing. De modo consciente o inconsciente, estaban empujando al sistema en una dirección incómoda. A medida que los chatbots asimilan nuestras palabras y nos las devuelven, pueden reforzar y amplificar nuestras creencias y convencernos de creer en lo que nos dicen.

Sejnowski formaba parte de un minúsculo grupo de investigadores que a finales de la década de 1970 y principios de 1980 empezaron a explorar seriamente un tipo de inteligencia artificial llamada red neuronal, que impulsa los chatbots actuales.

Una red neuronal es un sistema matemático que aprende habilidades analizando datos digitales. Es la misma tecnología que permite a Siri y Alexa reconocer lo que dices.

Alrededor de 2018, los investigadores de empresas como Google y OpenAI comenzaron a construir redes neuronales que aprendían de grandes cantidades de texto digital, incluidos libros, artículos de Wikipedia, registros de chat y otras cosas publicadas en internet. Al localizar miles de millones de patrones en todo ese texto, estos LLM aprendieron a generar texto por sí mismos, incluidos tuits, publicaciones en blogs, discursos y programas de computación. Incluso eran capaces de mantener una conversación.

Estos sistemas son un reflejo de la humanidad. Aprenden sus habilidades analizando el texto que los humanos han publicado en internet.

Pero esa no es la única razón por la que los chatbots generan un lenguaje problemático, afirma Melanie Mitchell, investigadora de Inteligencia Artificial del Santa Fe Institute, un laboratorio independiente de Nuevo México.

Melanie Mitchell, investigadora de Inteligencia Artificial del Santa Fe Institute, ha estudiado cómo generan sus resultados los chatbots

Cuando generan texto, estos sistemas no repiten palabra por palabra lo que hay en Internet. Producen texto nuevo por sí mismos combinando miles de millones de patrones.

Incluso si los investigadores entrenaran a estos sistemas únicamente con literatura científica revisada por pares, podrían producir afirmaciones científicamente ridículas. Incluso si aprendieran únicamente de textos verídicos, podrían producir falsedades. Incluso si solo aprendieran de textos íntegros, podrían producir algo espeluznante.

“No hay nada que les impida hacerlo”, afirma Mitchell. “Solo intentan producir algo que suene a lenguaje humano”.

Los expertos en inteligencia artificial saben desde hace tiempo que esta tecnología muestra todo tipo de comportamientos inesperados. Pero no siempre se ponen de acuerdo sobre cómo debe interpretarse este comportamiento o con qué rapidez mejorarán los chatbots.

Debido a que estos sistemas aprenden a partir de muchos más datos de los que los humanos podríamos llegar a comprender, ni siquiera los expertos en inteligencia artificial pueden entender por qué generan un texto en particular en un momento determinado.

Sejnowski comentó que cree que, a largo plazo, los nuevos chatbots tendrán la capacidad de aumentar la eficacia de las personas y ofrecerles maneras para realizar tareas mejor y más rápido. No obstante, hay una advertencia tanto para las empresas que construyen estos chatbots como para las personas que los utilizan: también pueden alejarnos de la verdad y llevarnos a lugares oscuros.

“Este es un terreno inexplorado”, mencionó Sejnowski. “Los humanos nunca lo habían experimentado”.

– Por qué los chatbots se están poniendo más inteligentes

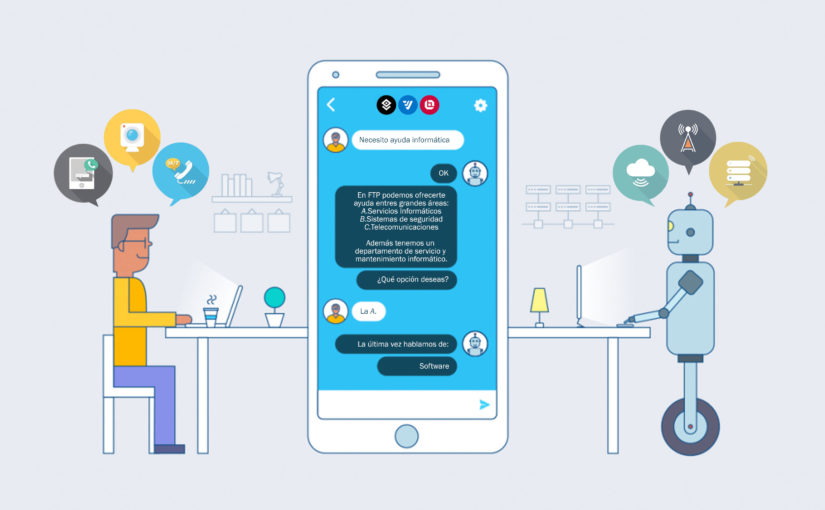

Un aparato doméstico tiene una falla y necesitas ayuda. O tienes una duda sobre la logística de un viaje o la cobertura de tu seguro. Te metes en el sitio web de la compañía y un ser digital brota en una pequeña ventana de texto. “¿Cómo puedo ayudarte?”, pregunta. O llamas a un número de servicio a clientes y un autómata alegre formula la misma pregunta.

Te armas de valentía y decides continuar, ya sea que teclees o le digas de viva voz al chatbot (o bot conversacional o de charla) lo que deseas. Sus respuestas programadas no cubren tus necesidades. En realidad, no te entiende. Después de varios minutos de un intercambio lingüístico incómodo, te desesperas y te rindes.

Esa experiencia es tan común que los expertos en atención al cliente tienen un término para ello: la espiral del sufrimiento.

Pero hay buenas noticias. Los chatbots de atención al cliente se están volviendo menos robóticos. Además, según investigadores, analistas y ejecutivos de la industria, están en proceso de mejorar de manera significativa durante los próximos años, debido a los avances en inteligencia artificial. Serán más inteligentes, más conversacionales, más parecidos a los humanos y, lo más importante, podrán brindar una mejor atención.

“Incluso ahora, hay ocasiones en las que casi ni te das cuenta de que no es un humano”, afirmó Bern Elliot, un analista en Gartner, una firma de investigación tecnológica. “No son tan buenos como quisieras que fueran, pero avanzan en esa dirección. Y la innovación está ocurriendo a un ritmo veloz”.

En los proyectos de investigación, la inteligencia artificial ha logrado hazañas asombrosas respecto a la comprensión y la producción de lenguaje, conocidas como procesamiento del lenguaje natural. El software de inteligencia artificial puede escribir historias y poemas, responder a preguntas de trivia, traducir decenas de idiomas e incluso ha creado programas de computadora. Estos proyectos habitualmente tienen un poder computacional ilimitado y son capaces de aprovechar volúmenes ilimitados de datos ya disponibles en toda la web.

El software de los asistentes digitales para consumidores, como Siri de Apple y Alexa de Amazon, también deambula por la web abierta para responder a preguntas.

No obstante, para la mayoría de las compañías, todo está más restringido. La información de sus clientes, necesaria para responder preguntas, no se encuentra en la web, sino al interior de los centros de datos corporativos. En comparación con los gigantes de internet, tienen menos datos, que han ido acumulando a través de los años y están almacenados en formatos diferentes y en diversos lugares. (Los algoritmos de inteligencia artificial batallan si no disponen de una gran cantidad de datos). Es más una excavación geológica que un escaneo en internet.

La solución de ese problema se ha convertido en un mercado emergente y cada vez más saturado, llamado inteligencia artificial conversacional. Las grandes corporaciones tecnológicas como Microsoft, Amazon, Google y Oracle tienen propuestas, al igual que compañías más pequeñas y empresas emergentes como Kore.ai, Omilia, Rasa, Senseforth.ai, Verint y Yellow.ai.

Los proveedores suministran herramientas de software que las compañías después personalizan y al que le incorporan sus propios datos.

Este año, el mercado de negocios para los asistentes virtuales —también conocidos como chatbots— crecerá un 15 por ciento para llegar a más de 7000 millones de dólares, según un pronóstico de Gartner. Algunos de estos bots están diseñados para asistir a los empleados, pero la mayoría se destinan a atención al cliente.

Ninguna compañía ha recorrido un camino más aleccionador e instructivo para su tecnología de chatbots que IBM. Después de que su supercomputadora Watson triunfó y venció a campeones humanos en el programa televisivo de concursos Jeopardy! hace una década, IBM decidió aplicar el procesamiento del lenguaje natural de Watson a otros campos. Uno de los primeros enfoques fue el diagnóstico y el tratamiento del cáncer e IBM calificó el área del cuidado de la salud como su “objetivo utópico”.

En enero, tras batallar durante varios años, IBM anunció que vendería su división de negocio de Salud Watson a una firma de capital privado. Algunos días después, Gartner calificó al Asistente Watson de IBM como un “líder” en inteligencia artificial conversacional para negocios. Watson ha pasado de ser una quimera para tratar el cáncer a chatbots de atención al cliente.

En la actualidad, el Asistente Watson es un caso de éxito para IBM entre sus productos restantes de inteligencia artificial, los cuales incluyen software para explorar datos y automatizar tareas de negocio. El Asistente Watson ha evolucionado con el paso de los años, ya que ha sido refinado y mejorado. IBM aprendió bastante pronto que un enfoque de pregunta-respuesta rígido, aunque resultaba ideal para un programa de concursos, era demasiado limitado e inflexible para una situación de atención a clientes.

“El mundo real nos abrió los ojos”, comentó Aya Soffer, vicepresidenta de tecnologías de inteligencia artificial en investigación de IBM.

El punto de partida para la mejora, dijo Soffer, ha sido una comprensión más profunda de lo que ocurre en los centros de llamadas, al trabajar con otras empresas para extraer y analizar muchos miles de charlas entre clientes y agentes humanos. En los diálogos, por ejemplo, dijo que se rastreó qué preguntas y qué seguimientos llevaban a resolver el problema de un cliente, y cuáles eran las señales reveladoras de “conversaciones que terminaban mal”.

Los primeros chatbots se programaban con un conjunto predeterminado de preguntas y respuestas. Pero eso llevaba a callejones sin salida si el software no entendía las preguntas. Hoy en día, dijo Soffer, gran parte de la innovación reciente radica en “enseñar al sistema a entender y descifrar la intención de una persona”.

Crear un software que pueda determinar la esencia de la solicitud de una persona es un gran desafío. “Asumes que solo hay cierta cantidad de maneras en la que una persona puede decir algo, pero descubres que eso en realidad no es verdad”, afirmó Bob Beatty, director de experiencia en la división de Servicios Financieros de General Motors (GM).

Al principio, el departamento de Servicios Financieros de GM tenía un chatbot rudimentario que simplemente pronunciaba respuestas programadas conforme a una lista de preguntas. Sin embargo, comenzó a trabajar con IBM en 2019 para desarrollar un chatbot interactivo. Los Servicios Financieros de GM tenían un plan de dos años para desarrollar e implementar su chatbot, impulsado por el Asistente Watson.

Los confinamientos por la pandemia de coronavirus en marzo de 2020 supusieron una aceleración sorpresiva de ese calendario. Beatty envió a trabajar desde casa a cerca de 700 agentes que laboraban en los centros de atención telefónica de la compañía en Arlington, Texas, y Chandler, Arizona. Mientras se apresuraban a equipar a los agentes de atención telefónica para el trabajo remoto, Servicios Financieros de GM redirigió a los clientes hacia su incipiente chatbot en lugar de hacia el teléfono a través de correos electrónicos y un aviso en su sitio web.

El chatbot enfrentó problemas al principio. Sin embargo, los desarrolladores de Servicios Financieros de GM y los ingenieros de IBM programaron en los bots la capacidad de responder a cada vez más preguntas —sin importar cómo se formaban las frases—, como “¿Cuál es mi monto de pago?” o “¿Recibieron mi pago de marzo?”.

No obstante, incluso las preguntas sencillas requieren respuestas personalizadas que el software debe buscar en la base de datos de una compañía. Cuando comenzó, el chatbot llamado Nanci (su nombre es parte de la palabra “fiNANCIeros”) resolvía menos del diez por ciento de las peticiones de los clientes. Sin embargo, dos meses después, la tasa de éxito se elevó al 50 por ciento (y ahora alcanzó el 60 por ciento), según Servicios Financieros de GM.

Hasta ahora, Nanci ha sido un chatbot solo de texto, pero la empresa está añadiendo una versión de voz. Y está trabajando con IBM para automatizar tareas más complejas, como la modificación de las fechas de pago y vencimiento.

El objetivo principal de la tecnología chatbot, según Beatty, es mejorar la experiencia del cliente y fomentar la fidelidad a la marca de su empresa matriz, General Motors. Pero la consulta media en un centro de llamadas dura seis minutos y cuesta 16 dólares, según las estimaciones del sector. En Servicios Financieros de GM, muchas de las preguntas de los clientes se responden ahora con el chatbot. En enero, Beatty estimó que la empresa ahorró un total de 935.000 dólares.

Hasta el momento, el personal del centro de atención telefónica no ha sido recortado. Beatty aseguró que la tecnología permitirá a los agentes pasar más tiempo en problemas difíciles (por ejemplo, hablar con un cliente que perdió su trabajo y necesita un préstamo o extender el arrendamiento de su vehículo).

“Eso es algo que un miembro de equipo capacitado y empático puede hacer de una manera que la inteligencia artificial no puede lograrlo”, señaló.

En el caso de la mayoría de los negocios, un obstáculo para lograr un avance con la inteligencia artificial es no tener suficientes datos para entrenarla. El software moderno de inteligencia artificial requiere grandes cantidades de datos que se debe examinar de forma detallada con el fin de mejorar su precisión (es decir, para que aprenda a su manera). Cierta tecnología nueva de inteligencia artificial podría superar ese obstáculo generando en automático más datos para entrenamiento o para aprender de menores cantidades de datos.

Anthem, una de las principales aseguradoras de salud, cubre a más de 45 millones de personas, tiene bastantes datos y además cuenta con un personal de tecnología de algunos miles de empleados que incluyen a científicos de datos, expertos en inteligencia artificial y desarrolladores de aplicaciones. El Asistente Watson de IBM es una de las muchas herramientas que Anthem usa.

Anthem muestra lo que está ocurriendo en la actualidad con los chatbots que operan con ayuda de la inteligencia artificial, pero también lo que sería posible dentro de algunos años. Su tecnología actual, incluyendo su aplicación móvil, se llama Sydney y, según la compañía, es 90 por ciento precisa al responder a preguntas sobre copagos (“Me someteré a una operación de remplazo de rodilla. ¿Cuánto cubre mi seguro?”) y medicamentos (“¿Mi receta tiene alguna interacción con otros fármacos?”).

No obstante, la meta a largo plazo, indicó Rajeev Ronanki, presidente de plataformas digitales en Anthem, es utilizar la inteligencia artificial para examinar con cuidado todas sus solicitudes y datos clínicos a fin de brindar asesoría de salud personalizada. Y otros tipos de datos: Sydney puede incluso tomar en cuenta la información de los monitores de acondicionamiento físico.

Por ejemplo, existen más de 380 opciones de cuidados y tratamientos para personas con diabetes, señaló Ronanki. ¿Cuáles han sido los regímenes de dieta, ejercicio y medicación que han producido los mejores resultados para pacientes similares (por edad, sexo, otras enfermedades e historial médico)?

Esa información podría ser proporcionada como recomendaciones de tratamiento a un médico y como consejos de salud a un individuo a través de un chatbot cada vez más inteligente y conversacional.

Ronanki dijo que la inteligencia artificial puede “ayudarnos a pasar de cuidado reactivo de enfermos a una atención de salud proactiva, predictiva y personalizada”.

Así como a una solución, tal vez, de la espiral del sufrimiento.

Deja un comentario