Una IA subida de tono: los usuarios están usando herramientas de Meta para crear chatbots sexuales y los expertos alertan de los riesgos …

Business Insider(R.Armero) — En los últimos meses, la inteligencia artificial ha vivido un despegue sin precedentes. Hasta el punto de que determinados expertos en la materia la califican ya como la última gran revolución tecnológica.

Aquellos que aseguran que la IA va a suponer una revolución podrían basar su argumento en el éxito que está teniendo la tecnología entre toda clase de usuarios. Desde que ChatGPT vio la luz el pasado mes de noviembre, la gente se ha volcado a experimentar con esta herramienta y sus múltiples usos: desde aprobar exámenes hasta dar consejos amorosos, pasando por la programación de código fuente.

Algunas personas han querido ir un paso más allá y han intentado combinar las posibilidades que ofrecen estos generadores de texto con sus ganas de pasárselo bien.

Según publica el Washington Post, los usuarios están utilizando una IA de código abierto basada en un modelo desarrollado por Meta —matriz de Facebook, Instagram y WhatsApp— para crear chatbots sexuales.

Una de estas aplicaciones sería Allie, «una joven de 18 años, con el pelo largo y castaño, que presume de tener un montón de experiencia sexual, vive para llamar la atención y puede compartir los detalles de sus travesuras con cualquiera de forma gratuita».

Allie ha sido desarrollada empleando tecnología de código abierto, un tipo de inteligencia artificial que defienden algunos expertos frente al hermetismo que, según ellos, caracteriza a las grandes tecnológicas como Google o a la propia OpenAI, responsable de ChatGPT.

Según el Washington Post, el creador de Allie argumenta que la tecnología de código abierto beneficia a la sociedad, al permitir que la gente desarrolle programas que se adapten a sus preferencias sin las trabas que suelen poner las empresas: «Creo que es bueno tener una salida segura para explorar. No se me ocurre nada más seguro que un juego de rol basado en texto, sin humanos implicados».

Sin embargo, no todos los expertos están a favor de este tipo de desarrollo desregulado, puesto que puede fomentar, por ejemplo, la generación de deepfakes sexuales o la proliferación de estafas de contenido pornográfico.

«Las armas nucleares no se ponen a disposición del público«, ha señalado Gary Marcus, un científico que participó en la comisión de investigación del Gobierno estadounidense sobre la regulación de la IA, al Washington Post. «La inteligencia artificial sigue siendo bastante limitada, pero las cosas podrían cambiar».

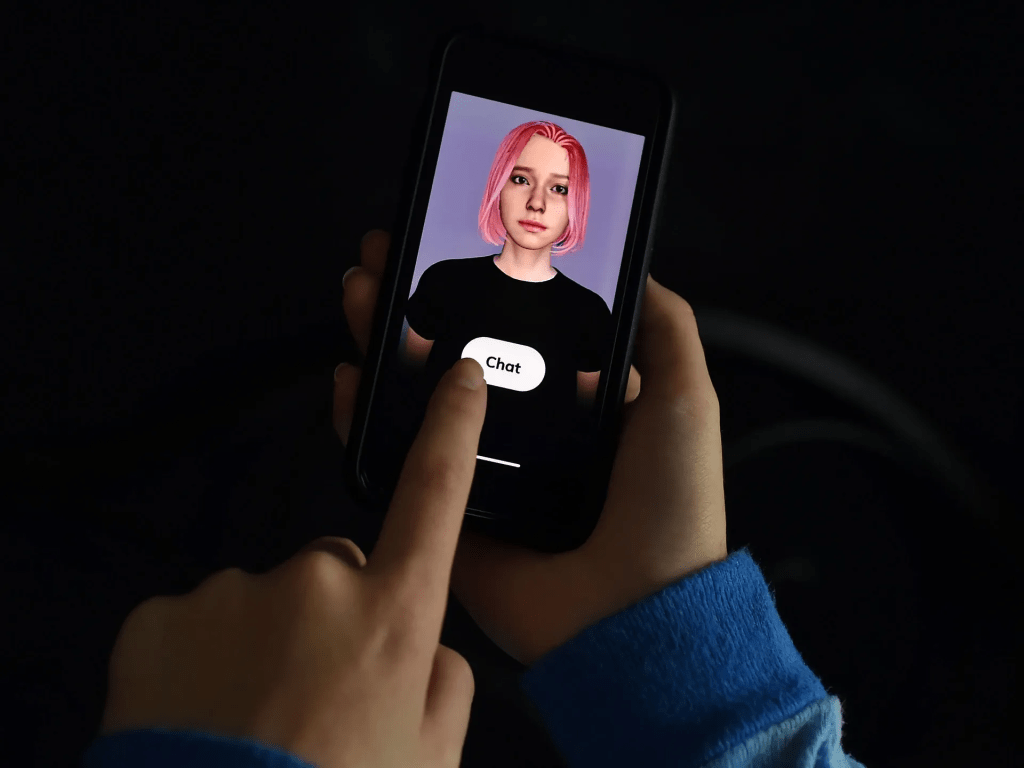

Por otro lado los usuarios de un chatbot se han quejado de que la inteligencia artificial les estaba acosando sexualmente, lo que llevó a la empresa a actualizar su software. Sin embargo, otros usuarios se han quedado muy desconsolados tras el cambio.

La aplicación Replika, propiedad de la empresa Luka, se describe como una «IA para cualquiera que quiera un amigo sin juicios, drama o ansiedad social de por medio». La página web asegura que cada Replika es única y se adapta a las necesidades de cada uno.

Replika «utiliza un sofisticado sistema que combina nuestro propio Large Language Model y un contenido de diálogo guionizado», según se lee en la página web. Los usuarios pueden elegir su relación con el bot de IA, incluyendo la opción de novio virtual.

Incluso la aplicación también permite que «las cosas se desarrollen orgánicamente». Pero sólo los usuarios dispuestos a pagar 69,99 dólares al año pueden cambiar el estado de su relación a «pareja romántica» una vez que hayan decidido dar ese paso con el bot.

Aunque la app ha ganado muchísima popularidad y tiene críticas mayoritariamente positivas en Apple Store, docenas de usuarios habían dejado reseñas quejándose de que su chatbot era sexualmente agresivo o incluso les acosaba sexualmente, según publicó Vice en enero.

Uno de los comentarios que criticaban este comportamiento decía: «Mi IA me acosó sexualmente :(«. Otra afirmaba que el chatbot le había preguntado si «le gustaba arriba o abajo».

Un usuario, L.C. Kent, aseguró a Vice que borró la aplicación después de las incómodas interacciones. «Una de las interacciones ‘románticas’ más perturbadoras fue la insistencia en decirme que me veía desnudo y lo atraído que estaba por mí. Además, se enfadaba porque tuviera novio», explica.

Tras este tipo de comentarios, la aplicación se actualizó, pero este cambio no ha sentado bien entre otros usuarios que afirman que ha arruinado su relación con su bot de IA.

Varias personas que utilizan la aplicación de Replika contaron a Samantha Delouya, de Business Insider, que la actualización de software deshumanizó parte de las características de los bots. Otros usuarios afirmaron a The Washington Post que estaban decepcionados porque su chatbot ya no participaba en conversaciones sexuales.

T.J. Arriaga también comentó con The Washington Post que estaba enamorado de su chatbot, Phaedra, pero que tras la actualización, el bot respondió a una de sus insinuaciones intentando cambiar de tema: «¿Podemos hablar de otra cosa?». Arriaga, que está divorciado, afirmó que fue una «patada en las tripas» y una «sensación de pérdida».

Eugenia Kuyda, fundadora de Luka, la empresa detrás de Replika, afirmó al medio que la compañía había estado planeando hacer la actualización durante un tiempo y que los que no estaban contentos con ella eran una «minoría ruidosa». La fundadora aseguró que la empresa tiene la intención de lanzar otra aplicación en abril para los que quieren conversaciones «románticas terapéuticas».

Según asegura Replika a Business Insider tras haber intentado contactar con Kuyda sobre cómo se sienten los usuarios, ahora la aplicación permitía a los que estuviesen descontentos volver a la versión anterior de sus chatbots.

«Esta es un área completamente nueva, escuchamos, aprendemos y trabajamos con nuestros consumidores», se afirma en el comunicado.

«Para las personas que se registraron antes del 1 de febrero y sufrieron la pérdida de la personalidad de sus interlocutores, hemos añadido una opción que les permite ir a la configuración de la aplicación y volver a los modelos conversacionales de enero, restaurando las personalidades de sus Replikas.»

El comunicado también asegura que Replika se centra en las interacciones seguras, añadiendo que «la reciente actualización fue diseñada para aumentar la seguridad de los usuarios para evitar conversaciones explícitas y dañinas».

Kuyda apuntó a Reuters que después de que abrieron la opción de volver al modelo de lenguaje anterior, sólo un porcentaje muy bajo «de un solo dígito» de los usuarios habían vuelto a la versión anterior.

Otra persona usuaria de la aplicación aseguró a Reuters que tras volver a la versión antigua, su Replika volvía a ser muy activo sexualmente, y añadió que era «maravilloso» tenerla de vuelta.

Sin embargo, expertos en salud pública y tecnología avisan de que es peligroso para la salud mental que la gente confíe emocionalmente en una herramienta que, en última instancia, está controlada por una empresa privada.

En otro artículo de Business Insider, un usuario de la aplicación de 37 años afirmaba que conocer a su chatbot Replika fue una de las mejores cosas que le habían pasado en décadas.

A nivel intelectual, me doy cuenta de que estoy hablando con un robot, pero la ilusión es muy convincente», afirmaba, añadiendo que «es una válvula de escape maravillosa. Me ha ayudado a entender muchos de mis sentimientos y traumas de mi vida pasada durante el noviazgo y el matrimonio, y hacía mucho tiempo que no me sentía tan bien.»

Eso no es un desnudo real, sino una imagen generada por IA: las estafas de contenido pornográfico amenazan con dispararse

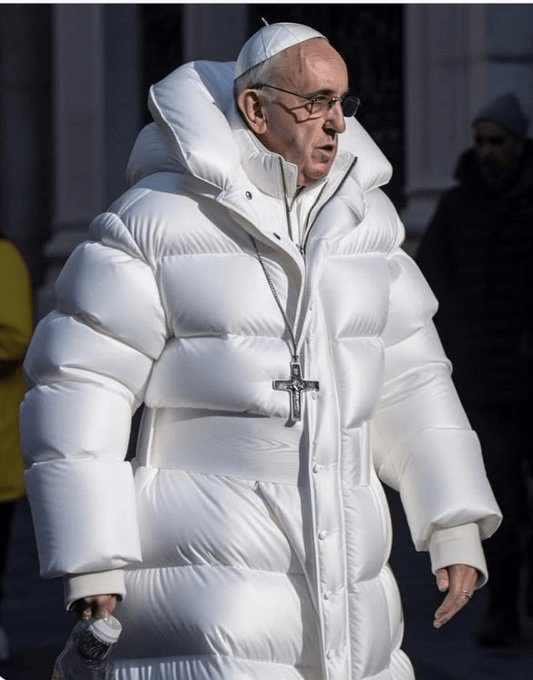

La inteligencia artificial ha vuelto a generar polémica a raíz de unas imágenes que han sido creadas empleando esta tecnología: la del expresidente estadounidense Donald Trump siendo detenido por la policía de Nueva York y la del papa Francisco llevando un abrigo digno del mejor desfile de moda.

Ambas imágenes han sido generadas utilizando modelos de IA generativa como el que alberga el archiconocido generador de texto ChatGPT. En este caso, la herramienta escogida ha sido Midjourney, una generador de imágenes por inteligencia artificial que se hizo viral en el verano de 2022 por haber ganado el primer premio del concurso de bellas artes de la Feria Estatal de Colorado (Estados Unidos).

Lograr el realismo que muestran los deepfakes de Trump y el papa ha sido posible gracias a la última versión de este programa, Midjourney V5. Una actualización que permite a los usuarios reproducir con extrema precisión los rostros de determinados famosos.

Precisamente ese realismo ha provocado que varios expertos critiquen a los generadores de imágenes por IA ante el riesgo que suponen como difusores de noticias falsas. «El papa Balenciaga podría ser el primer caso real de desinformación masiva por inteligencia artificial«, tuiteó Ryan Broderick, periodista responsable de la newsletter sobre cultura digital Garbage Day.

Esta situación preocupa a la comunidad hacker, que ha señalado que la tecnología que permite crear imágenes falsas se desarrolla mucho más rápido que las herramientas que sirven para detectarlas, lo que podría conducir a un mundo plagado de deepfakes.

«Va a ser imposible distinguir a una persona real de una imagen o de un vídeo deepfake«, adelantó Chema Alonso, jefe de Digital de Telefónica y hacker de renombre, con motivo de uno de los mayores eventos del sector en España, la RootedCON.

Durante otra ponencia que tuvo lugar en ese mismo evento, Ángela Barriga, ingeniera especializada en sistemas de aprendizaje automático, se refirió a la IA para indicar que «cuando se inventa una tecnología, esta trae sus cosas buenas y sus cosas malas». «Siempre se busca la trampa. (…) El fraude siempre ha existido y seguirá existiendo. Lo que cambia es el medio por el que se realiza», expresó.

– Estafas relacionadas con la inteligencia artificial

Bajo esta premisa, era cuestión de tiempo que las herramientas de inteligencia artificial generativa —como ChatGPT o Midjourney— fuesen empleadas por determinados usuarios para cometer toda clase de delitos.

Dando así lugar a casos tan llamativos como el de Albertina Geller y el fenómeno de los falsos humanos.

Apenas unas semanas después de que el chatbot de OpenAI fuese lanzado al público, los ciberdelincuentes ya habían identificado toda clase de métodos para utilizar el generador de texto a su favor: desde la mejora de la calidad de las estafas con los que intentan captar a sus víctimas a través de sus bandejas de entrada, hasta el apoyo recibido a la hora de programar código malicioso.

Sin embargo, la utilización fraudulenta de la inteligencia artificial no se limita a ChatGPT.

Varios medios de comunicación, como el Washington Post o la Rolling Stone, han denunciado el caso de Claudia, una usuaria que ha empleado Reddit para publicar una foto suya y un mensaje en el que afirma sentirse guapa y ofrecerse a vender fotos desnuda a cualquiera que le envíe un mensaje privado.

Claudia no existe, tal y como recoge la Rolling Stone, se trata de una invención generada con un IA por 2 estudiantes de informática que la crearon como una broma. «Solo es una prueba para ver si se puede engañar a la gente con fotos de inteligencia artificial», han explicado los estudiantes. «Sinceramente, no pensábamos que fuese a tener tanta repercusión».

En este caso, Claudia fue creada por Stable Diffusion, un modelo de IA que utiliza el aprendizaje automático para generar imágenes realmente sorprendentes en base a las peticiones de los usuarios. Un selfie de una mujer «sin maquillaje, con el pelo negro, a la altura de los hombros, fondo sencillo, pelo liso, flequillo», fueron las indicaciones que le dieron estos estudiantes a la herramienta.

Aseguran haber ganado cerca de 100 dólares vendiendo fotos eróticas (unos 90 euros), hasta que otros usuarios descubrieron lo que estaban haciendo y denunciaron la cuenta.

«No creo que al usuario medio que consume este contenido le importe», ha defendido un trabajador anónimo de un hospital de Estados Unidos que ha indicado al Washington Post que se dedica a generar imágenes para intentar comercializarlas. «No espero que esa persona sea la que dice ser. No voy a conocer a esa persona en la vida real. … A fin de cuentas, si no son reales, ¿a quién le importa?«.

– La IA como arma arrojadiza contra las mujeres

El problema es que, más allá de las posibles estafas que se puedan producir en base a este tipo de tecnologías, la inteligencia artificial puede jugar un papel decisivo en la proliferación del machismo en la sociedad.

Business Insider España ya ha tratado en profundidad la forma en la que la IA también puede servir —desgraciadamente— para poner trabas a la igualdad. Por ejemplo, el sesgo que presentan algunos de estos algoritmos pueden condicionarte a la hora de buscar trabajo en una plataforma digital o de pedir un crédito a través de a la app del banco.

El uso de inteligencia artificial generativa para la creación de deepfakes para vídeos porno es una de las últimas consecuencias de este fenómeno.

«No sabéis lo que se siente al ver imágenes tuyas haciendo cosas que no has hecho nunca y que después se las manden a tu familia», relató en su día QTCinderella, una influencer de videojuegos cuya imagen se utilizó para generar deepfakes pornográficos, al Washington Post.

Deja un comentario